Gram-Schmidt-processen

av Marco Taboga, PhD

Gram-Schmidt-processen (eller förfarandet) är en sekvens av operationer som gör det möjligt att omvandla en uppsättning linjärt oberoende vektorer till en uppsättning ortonormala vektorer som spänner över samma utrymme som den ursprungliga uppsättningen.

Preliminarier

Låt oss gå igenom några begrepp som är viktiga för att förstå Gram-Schmidt-processen.

Kom ihåg att två vektorer  och

och  sägs vara ortogonala om och endast om deras inre produkt är lika med noll, det vill säga,

sägs vara ortogonala om och endast om deras inre produkt är lika med noll, det vill säga,

Givet en inre produkt kan vi definiera normen (längden) för en vektor  enligt följande:

enligt följande:

En uppsättning vektorer kallas ortonormal om och endast om dess element har enhetsnorm och är ortogonala till varandra. Med andra ord är en uppsättning  vektorer

vektorer  ortonormal om och endast om

ortonormal om och endast om

Vi har bevisat att vektorerna i en ortonormal uppsättning är linjärt oberoende.

När en bas för ett vektorrum också är en ortonormal uppsättning kallas den för en ortonormal bas.

Projektioner på ortonormala uppsättningar

I Gram-Schmidt-processen använder vi upprepade gånger nästa sats, som visar att varje vektor kan sönderdelas i två delar: 1) dess projektion på en ortonormal uppsättning och 2) en rest som är ortogonal till den givna ortonormala uppsättningen.

Sats Låt  vara ett vektorutrymme utrustat med en inre produkt

vara ett vektorutrymme utrustat med en inre produkt  . Låt

. Låt  vara en ortonormal mängd. För varje

vara en ortonormal mängd. För varje  har vi

har vi där

där  är ortogonal till

är ortogonal till  för varje

för varje

Definiera Då har vi för varje

Då har vi för varje  att

att här: i stegen

här: i stegen  och

och  har vi använt det faktum att den inre produkten är linjär i sitt första argument; I steg

har vi använt det faktum att den inre produkten är linjär i sitt första argument; I steg  har vi använt det faktum att

har vi använt det faktum att  om

om  eftersom vi har att göra med en ortonormal mängd; i steg

eftersom vi har att göra med en ortonormal mängd; i steg  har vi använt det faktum att normen för

har vi använt det faktum att normen för  är lika med 1. Därför är

är lika med 1. Därför är  , enligt definitionen ovan, ortogonal till alla element i den ortonormala mängden, vilket bevisar satsen.

, enligt definitionen ovan, ortogonal till alla element i den ortonormala mängden, vilket bevisar satsen.

Termen kallas den linjära projektionen av

kallas den linjära projektionen av  på den ortonormala mängden

på den ortonormala mängden  , medan termen

, medan termen  kallas restvärdet av den linjära projektionen.

kallas restvärdet av den linjära projektionen.

Normalisering

Ett annat kanske självklart faktum som vi kommer att använda upprepade gånger i Gram-Schmidt-processen är att om vi tar en vektor som inte är noll och vi dividerar den med dess norm, så är resultatet av divisionen en ny vektor som har enhetsnorm.

Med andra ord, om  så har vi, genom normens bestämdhetsegenskap, att

så har vi, genom normens bestämdhetsegenskap, att

Som en följd av detta kan vi definiera och, genom normens positivitet och absoluta homogenitet, har vi

och, genom normens positivitet och absoluta homogenitet, har vi

Översikt över förfarandet

Nu när vi vet hur man normaliserar en vektor och hur man dekomponerar den i en projektion på en ortonormal uppsättning och en rest, är vi redo att förklara Gram-Schmidt-förfarandet.

Vi kommer att ge en översikt över förfarandet, varefter vi kommer att uttrycka det formellt som en sats och vi kommer att diskutera alla tekniska detaljer i beviset för satsen.

Här är översikten.

Vi får en uppsättning linjärt oberoende vektorer  .

.

För att starta processen normaliserar vi den första vektorn, det vill säga vi definierar

I det andra steget projicerar vi  på

på  :

: där

där  är restvärdet av projektionen.

är restvärdet av projektionen.

Därefter normaliserar vi restvärdet:

Vi kommer senare att bevisa att  (så att normaliseringen kan utföras) eftersom startvektorerna är linjärt oberoende.

(så att normaliseringen kan utföras) eftersom startvektorerna är linjärt oberoende.

De två vektorerna  och

och  som på så sätt erhålls är ortonormala.

som på så sätt erhålls är ortonormala.

I det tredje steget projicerar vi  på

på  och

och  :

: och vi beräknar residualen av projektionen

och vi beräknar residualen av projektionen  .

.

Vi normaliserar den sedan:

Vi fortsätter på detta sätt tills vi får den sista normaliserade residualen  .

.

I slutet av processen bildar vektorerna  en ortonormal uppsättning eftersom:

en ortonormal uppsättning eftersom:

-

de är resultatet av en normalisering, och som en följd av detta har de en enhetsnorm;

-

varje

erhålls från en rest som har egenskapen att vara ortogonal till

erhålls från en rest som har egenskapen att vara ortogonal till  .

.

För att komplettera denna översikt, låt oss komma ihåg att det linjära spannet av  är mängden av alla vektorer som kan skrivas som linjära kombinationer av

är mängden av alla vektorer som kan skrivas som linjära kombinationer av  ; det betecknas med

; det betecknas med och det är ett linjärt rum.

och det är ett linjärt rum.

Eftersom vektorerna  är linjärt oberoende kombinationer av

är linjärt oberoende kombinationer av  , kan alla vektorer som kan skrivas som linjära kombinationer av

, kan alla vektorer som kan skrivas som linjära kombinationer av  också skrivas som linjära kombinationer av

också skrivas som linjära kombinationer av  . Därför sammanfaller spännvidderna för de två uppsättningarna av vektorer:

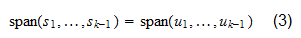

. Därför sammanfaller spännvidderna för de två uppsättningarna av vektorer:

Formellt uttalande

Vi formaliserar här Gram-Schmidt-processen som ett påstående, vars bevis innehåller alla tekniska detaljer om förfarandet.

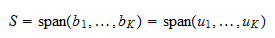

Sats Låt  vara ett vektorrum utrustat med en inre produkt

vara ett vektorrum utrustat med en inre produkt  . Låt

. Låt  vara linjärt oberoende vektorer. Då finns det en uppsättning ortonormala vektorer

vara linjärt oberoende vektorer. Då finns det en uppsättning ortonormala vektorer  så att

så att för varje

för varje  .

.

Beviset sker genom induktion: först bevisar vi att satsen är sann för  , och sedan bevisar vi att den är sann för en generisk

, och sedan bevisar vi att den är sann för en generisk  om den gäller för

om den gäller för  . När

. När  har vektorn

har vektorn enhetsnorm och utgör i sig själv en ortonormal mängd: det finns inga andra vektorer, så ortogonalitetsvillkoret är trivialt uppfyllt. Mängden

enhetsnorm och utgör i sig själv en ortonormal mängd: det finns inga andra vektorer, så ortogonalitetsvillkoret är trivialt uppfyllt. Mängden är mängden av alla skalära multiplar av

är mängden av alla skalära multiplar av  , som också är skalära multiplar av

, som också är skalära multiplar av  (och vice versa). Därför

(och vice versa). Därför  Antag nu att satsen är sann för

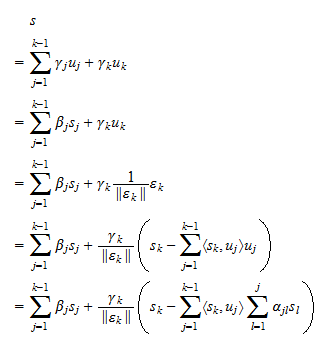

Antag nu att satsen är sann för  . Då kan vi projicera

. Då kan vi projicera  på

på  :

: där restvärdet

där restvärdet  är ortogonal till

är ortogonal till  . Anta att

. Anta att  . Då,

. Då, Då vi genom antagandet

Då vi genom antagandet  för varje

för varje  har vi att

har vi att  för varje

för varje  , där

, där  är skalarer. Därför,

är skalarer. Därför, Med andra ord leder antagandet att

Med andra ord leder antagandet att  till slutsatsen att

till slutsatsen att  är en linjär kombination av

är en linjär kombination av  . Men detta är omöjligt eftersom ett av antagandena i propositionen är att

. Men detta är omöjligt eftersom ett av antagandena i propositionen är att  är linjärt oberoende. Som en konsekvens av detta måste det vara så att

är linjärt oberoende. Som en konsekvens av detta måste det vara så att  . Vi kan därför normalisera restvärdet och definiera vektorn

. Vi kan därför normalisera restvärdet och definiera vektorn som har enhetsnorm. Vi vet redan att

som har enhetsnorm. Vi vet redan att  är ortogonal till

är ortogonal till  . Detta innebär att även

. Detta innebär att även  är ortogonal till

är ortogonal till  . Således är

. Således är  en ortonormal mängd. Ta nu någon vektor

en ortonormal mängd. Ta nu någon vektor  som kan skrivas som

som kan skrivas som där

där  är skalarer. Eftersom vi genom antagande

är skalarer. Eftersom vi genom antagande  har att ekvation (2) också kan skrivas som

har att ekvation (2) också kan skrivas som där

där  är skalärer, och: i steg

är skalärer, och: i steg  har vi använt oss av ekvation (1); i steg

har vi använt oss av ekvation (1); i steg  har vi använt oss av definitionen av

har vi använt oss av definitionen av  . Vi har alltså bevisat att varje vektor som kan skrivas som en linjär kombination av

. Vi har alltså bevisat att varje vektor som kan skrivas som en linjär kombination av  också kan skrivas som en linjär kombination av

också kan skrivas som en linjär kombination av  . Antagandet (3) gör det möjligt att bevisa det omvända på ett helt analogt sätt:

. Antagandet (3) gör det möjligt att bevisa det omvända på ett helt analogt sätt: Med andra ord är varje linjär kombination av

Med andra ord är varje linjär kombination av  också en linjär kombination av

också en linjär kombination av  . Detta bevisar att

. Detta bevisar att  och avslutar beviset.

och avslutar beviset.

Varje inre produktrum har en ortonormal bas

Följande sats presenterar en viktig konsekvens av Gram-Schmidt-processen.

Sats Låt  vara ett vektorrum utrustat med en inre produkt

vara ett vektorrum utrustat med en inre produkt  . Om

. Om  har ändlig dimension

har ändlig dimension  finns det en ortonormal bas

finns det en ortonormal bas  för

för  .

.

Då  har ändlig dimension, finns det minst en bas för

har ändlig dimension, finns det minst en bas för  som består av

som består av  vektorer

vektorer  . Vi kan tillämpa Gram-Schmidt-förfarandet på basen och få en ortonormal uppsättning

. Vi kan tillämpa Gram-Schmidt-förfarandet på basen och få en ortonormal uppsättning  . Eftersom

. Eftersom  är en bas sträcker den sig över

är en bas sträcker den sig över  . Därför

. Därför  Därmed är

Därmed är  en ortonormal bas av

en ortonormal bas av  .

.

Lösta övningar

Nedan hittar du några övningar med förklarade lösningar.

Övningsuppgift 1

Betrakta rummet  av alla

av alla  vektorer som har reella poster och den inre produkten

vektorer som har reella poster och den inre produkten där

där  och

och  är transponeringen av

är transponeringen av  . Definiera vektorn

. Definiera vektorn

Normalisera  .

.

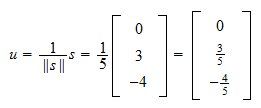

Normen för  är

är Därför, är normaliseringen av

Därför, är normaliseringen av

Övningsuppgift 2

Betrakta utrymmet  av alla

av alla  vektorer som har reella poster och den inre produkten

vektorer som har reella poster och den inre produkten varvid

varvid  . Betrakta de två linjärt oberoende vektorerna

. Betrakta de två linjärt oberoende vektorerna

Omvandla dem till en ortonormal uppsättning med hjälp av Gram-Schmidt-processen.

Normen för  är

är  Därför, den första ortonormala vektorn är

Därför, den första ortonormala vektorn är Den inre produkten av

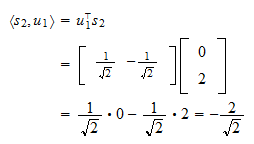

Den inre produkten av  och

och  är

är Projektionen av

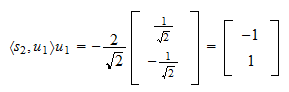

Projektionen av  på

på  är

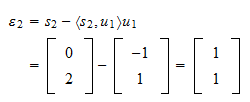

är Restvärdet av projektionen är

Restvärdet av projektionen är Restvärdet är

Restvärdet är och det normaliserade restvärdet är

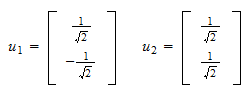

och det normaliserade restvärdet är Därmed, den ortonormala mängden vi letade efter är

Därmed, den ortonormala mängden vi letade efter är

How to cite

Please cite as:

Taboga, Marco (2017). ”Gram-Schmidt process”, Lectures on matrix algebra. https://www.statlect.com/matrix-algebra/Gram-Schmidt-process.

Leave a Reply