Processo Gram-Schmidt

por Marco Taboga, PhD

O processo (ou procedimento) Gram-Schmidt é uma seqüência de operações que permite transformar um conjunto de vetores linearmente independentes em um conjunto de vetores orto-normais que abrangem o mesmo espaço abrangido pelo conjunto original.

Preliminares

Vamos rever algumas noções que são essenciais para entender o processo Gram-Schmidt.

Lembrem-se que dois vetores  e

e  são ditos ortogonais se e somente se seu produto interno for igual a zero, ou seja,

são ditos ortogonais se e somente se seu produto interno for igual a zero, ou seja,

Dado um produto interno, podemos definir a norma (comprimento) de um vetor  da seguinte forma

da seguinte forma

Um conjunto de vectores é chamado orthonormal se e só se os seus elementos tiverem uma norma unitária e forem ortogonais uns aos outros. Em outras palavras, um conjunto de  vectores

vectores  é orthonormal se e somente se

é orthonormal se e somente se

Provamos que os vectores de um conjunto orthonormal são linearmente independentes.

Quando uma base para um espaço vectorial é também um conjunto orthonormal, ele é chamado de base orthonormal.

Projeções em conjuntos orthonormais

No processo Gram-Schmidt, usamos repetidamente a próxima proposta, que mostra que cada vetor pode ser decomposto em duas partes: 1) sua projeção em um conjunto orthonormal e 2) um residual que é ortogonal ao conjunto orthonormal dado.

Proposição Vamos  ser um espaço vetorial equipado com um produto interno

ser um espaço vetorial equipado com um produto interno  . Que

. Que  seja um conjunto orthonormal. Para qualquer

seja um conjunto orthonormal. Para qualquer  , temos

, temos onde

onde  é ortogonal a

é ortogonal a  para qualquer

para qualquer

Definir Então, para cada

Então, para cada  , temos isso

, temos isso em qualquer lugar: nos passos

em qualquer lugar: nos passos  e

e  usamos o fato de que o produto interno é linear em seu primeiro argumento; no passo

usamos o fato de que o produto interno é linear em seu primeiro argumento; no passo  usamos o fato de que

usamos o fato de que  if

if  já que estamos lidando com um conjunto orthonormal; no passo

já que estamos lidando com um conjunto orthonormal; no passo  usamos o fato de que a norma de

usamos o fato de que a norma de  é igual a 1. Portanto,

é igual a 1. Portanto,  , como definido acima, é ortogonal a todos os elementos do conjunto orthonormal, o que prova a proposição.

, como definido acima, é ortogonal a todos os elementos do conjunto orthonormal, o que prova a proposição.

O termo é chamado de projeção linear de

é chamado de projeção linear de  no conjunto orthonormal

no conjunto orthonormal  , enquanto o termo

, enquanto o termo  é chamado de resíduo da projeção linear.

é chamado de resíduo da projeção linear.

Normalização

Outro fato talvez óbvio que vamos usar repetidamente no processo Gram-Schmidt é que, se pegarmos qualquer vetor não-zero e o dividirmos por sua norma, então o resultado da divisão é um novo vetor que tem norma unitária.

Em outras palavras, se  então, pela propriedade de definição da norma, temos que

então, pela propriedade de definição da norma, temos que

Como consequência, podemos definir  e, pela positividade e homogeneidade absoluta da norma, temos

e, pela positividade e homogeneidade absoluta da norma, temos

Visão geral do procedimento

Agora que sabemos como normalizar um vector e como decompô-lo numa projecção num conjunto orto-normal e num residual, estamos prontos para explicar o procedimento Gram-Schmidt.

Vamos dar uma visão geral do processo, após o que o expressaremos formalmente como uma proposta e discutiremos todos os detalhes técnicos na prova da proposta.

Aqui está a visão geral.

Nos é dado um conjunto de vetores linearmente independentes  .

.

Para iniciar o processo, normalizamos o primeiro vector, ou seja, definimos

No segundo passo, projectamos  em

em  :

: onde

onde  é o resíduo da projecção.

é o resíduo da projecção.

Então, normalizamos o residual:

Mais tarde provaremos que  (para que a normalização possa ser feita) porque os vetores de partida são linearmente independentes.

(para que a normalização possa ser feita) porque os vetores de partida são linearmente independentes.

Os dois vetores  e

e  assim obtidos são orthonormais.

assim obtidos são orthonormais.

No terceiro passo, projetamos  em

em  e

e  :

: e calculamos o resíduo da projeção

e calculamos o resíduo da projeção  .

.

Depois normalizamos:

Procedemos desta forma até obter o último residual normalizado  .

.

Ao final do processo, os vetores  formam um conjunto orto-normal porque:

formam um conjunto orto-normal porque:

-

são o resultado de uma normalização, e como conseqüência têm norma unitária;

-

cada

é obtido de um resíduo que tem a propriedade de ser ortogonal a

é obtido de um resíduo que tem a propriedade de ser ortogonal a  .

.

Para completar esta visão geral, lembremos que o intervalo linear de  é o conjunto de todos os vectores que podem ser escritos como combinações lineares de

é o conjunto de todos os vectores que podem ser escritos como combinações lineares de  ; é denotado por

; é denotado por e é um espaço linear.

e é um espaço linear.

Uma vez que os vectores  são combinações linearmente independentes de

são combinações linearmente independentes de  , qualquer vector que possa ser escrito como uma combinação linear de

, qualquer vector que possa ser escrito como uma combinação linear de  também pode ser escrito como uma combinação linear de

também pode ser escrito como uma combinação linear de  . Portanto, os intervalos dos dois conjuntos de vetores coincidem:

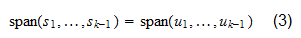

. Portanto, os intervalos dos dois conjuntos de vetores coincidem:

Declaração formal

Formalizamos aqui o processo Gram-Schmidt como uma proposta, cuja prova contém todos os detalhes técnicos do procedimento.

Proposição Let  ser um espaço vetorial equipado com um produto interno

ser um espaço vetorial equipado com um produto interno  . Deixar

. Deixar  ser vectores linearmente independentes. Então, existe um conjunto de vectores orto-normais

ser vectores linearmente independentes. Então, existe um conjunto de vectores orto-normais  tal que

tal que para qualquer

para qualquer  .

.

A prova é por indução: primeiro provamos que a proposta é verdadeira para  , e depois provamos que é verdadeira para um genérico

, e depois provamos que é verdadeira para um genérico  se for válida para

se for válida para  . Quando

. Quando  , o vector

, o vector tem uma norma unitária e constitui por si só um conjunto orthonormal: não existem outros vectores, pelo que a condição de ortogonalidade é trivialmente satisfeita. O conjunto

tem uma norma unitária e constitui por si só um conjunto orthonormal: não existem outros vectores, pelo que a condição de ortogonalidade é trivialmente satisfeita. O conjunto é o conjunto de todos os múltiplos escalares de

é o conjunto de todos os múltiplos escalares de  , que também são múltiplos escalares de

, que também são múltiplos escalares de  (e vice versa). Portanto,

(e vice versa). Portanto,  Agora, suponha que a proposta seja verdadeira para

Agora, suponha que a proposta seja verdadeira para  . Então, podemos projetar

. Então, podemos projetar  em

em  :

: onde o residual

onde o residual  é ortogonal para

é ortogonal para  . Suponha que

. Suponha que  . Então,

. Então, Desde que, por suposição,

Desde que, por suposição,  para qualquer

para qualquer  , temos que

, temos que  para qualquer

para qualquer  , onde

, onde  são escalares. Portanto,

são escalares. Portanto, Em outras palavras, a hipótese de que

Em outras palavras, a hipótese de que  leva à conclusão de que

leva à conclusão de que  é uma combinação linear de

é uma combinação linear de  . Mas isto é impossível porque uma das hipóteses da proposta é que

. Mas isto é impossível porque uma das hipóteses da proposta é que  são linearmente independentes. Como consequência, deve ser que

são linearmente independentes. Como consequência, deve ser que  . Podemos portanto normalizar o residual e definir o vetor

. Podemos portanto normalizar o residual e definir o vetor que tem norma unitária. Já sabemos que

que tem norma unitária. Já sabemos que  é ortogonal a

é ortogonal a  . Isto implica que também

. Isto implica que também  é ortogonal a

é ortogonal a  . Assim,

. Assim,  é um conjunto orthonormal. Agora, pegue qualquer vetor

é um conjunto orthonormal. Agora, pegue qualquer vetor  que pode ser escrito como

que pode ser escrito como onde

onde  são escalares. Como, por suposição,

são escalares. Como, por suposição,  temos essa equação (2) também pode ser escrita como

temos essa equação (2) também pode ser escrita como onde

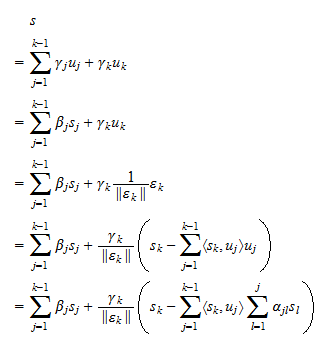

onde  são escalares, e: no passo

são escalares, e: no passo  usamos a equação (1); no passo

usamos a equação (1); no passo  usamos a definição de

usamos a definição de  . Assim, provamos que todo vetor que pode ser escrito como uma combinação linear de

. Assim, provamos que todo vetor que pode ser escrito como uma combinação linear de  também pode ser escrito como uma combinação linear de

também pode ser escrito como uma combinação linear de  . Assumir (3) permite provar o inverso de uma maneira completamente análoga:

. Assumir (3) permite provar o inverso de uma maneira completamente análoga: Em outras palavras, cada combinação linear de

Em outras palavras, cada combinação linear de  é também uma combinação linear de

é também uma combinação linear de  . Isto prova que

. Isto prova que  e conclui a prova.

e conclui a prova.

Cada espaço interior do produto tem uma base orto-normal

A seguinte proposta apresenta uma importante consequência do processo Gram-Schmidt.

Posição Que  seja um espaço vectorial equipado com um produto interior

seja um espaço vectorial equipado com um produto interior  . Se

. Se  tem dimensão finita

tem dimensão finita  , então existe uma base orthonormal

, então existe uma base orthonormal  para

para  .

.

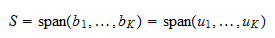

Desde que  seja de dimensão finita, existe pelo menos uma base para

seja de dimensão finita, existe pelo menos uma base para  , constituída por

, constituída por  vectores

vectores  . Podemos aplicar o procedimento Gram-Schmidt à base e obter um conjunto orthonormal

. Podemos aplicar o procedimento Gram-Schmidt à base e obter um conjunto orthonormal  . Como

. Como  é uma base, ela abrange

é uma base, ela abrange  . Portanto,

. Portanto,  Assim,

Assim,  é uma base orto-normal de

é uma base orto-normal de  .

.

>

>

Exercícios resolvidos

Abaixo você pode encontrar alguns exercícios com soluções explicadas.

Exercício 1

Considere o espaço  de todos

de todos  vectores com entradas reais e o produto interno

vectores com entradas reais e o produto interno onde

onde  e

e  é a transposição de

é a transposição de  . Define o vector

. Define o vector

Normalizar  .

.

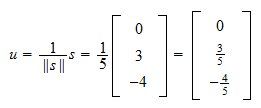

A norma de  é

é Por isso, a normalização de

Por isso, a normalização de  é

é

Exercício 2

Considere o espaço  de todos

de todos  vetores com entradas reais e o produto interno

vetores com entradas reais e o produto interno onde

onde  . Considere os dois vetores linearmente independentes

. Considere os dois vetores linearmente independentes

Transforme-os em um conjunto orthonormal usando o processo Gram-Schmidt.

A norma de  é

é  Por isso, o primeiro vector orthonormal é

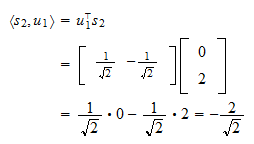

Por isso, o primeiro vector orthonormal é O produto interior de

O produto interior de  e

e  é

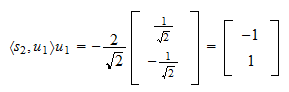

é A projecção de

A projecção de  em

em  é

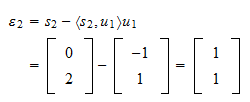

é O resíduo da projecção é

O resíduo da projecção é A norma do resíduo é

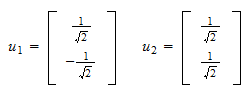

A norma do resíduo é e o resíduo normalizado é

e o resíduo normalizado é Assim, o conjunto orthonormal que procurávamos é

Assim, o conjunto orthonormal que procurávamos é

Como citar

Cite por favor como:

>

Taboga, Marco (2017). “Processo Gram-Schmidt”, Palestras sobre álgebra matricial. https://www.statlect.com/matrix-algebra/Gram-Schmidt-process.

Leave a Reply