Gram-Schmidt-Verfahren

von Marco Taboga, PhD

Das Gram-Schmidt-Verfahren (oder Verfahren) ist eine Folge von Operationen, die es ermöglichen, eine Menge linear unabhängiger Vektoren in eine Menge orthonormaler Vektoren umzuwandeln, die denselben Raum aufspannen wie die ursprüngliche Menge.

Vorüberlegungen

Wir wollen einige Begriffe wiederholen, die für das Verständnis des Gram-Schmidt-Verfahrens wesentlich sind.

Erinnern wir uns daran, dass zwei Vektoren  und

und  dann und nur dann orthogonal sind, wenn ihr inneres Produkt gleich Null ist, d.h.

dann und nur dann orthogonal sind, wenn ihr inneres Produkt gleich Null ist, d.h.

Bei einem inneren Produkt können wir die Norm (Länge) eines Vektors  wie folgt definieren:

wie folgt definieren:

Eine Menge von Vektoren heißt dann und nur dann orthonormal, wenn ihre Elemente eine Einheitsnorm haben und orthogonal zueinander sind. Mit anderen Worten, eine Menge von  Vektoren

Vektoren  ist orthonormal, wenn und nur wenn

ist orthonormal, wenn und nur wenn

Wir haben bewiesen, dass die Vektoren einer orthonormalen Menge linear unabhängig sind.

Wenn eine Basis für einen Vektorraum auch eine orthonormale Menge ist, nennt man sie eine orthonormale Basis.

Projektionen auf orthonormale Mengen

Im Gram-Schmidt-Verfahren verwenden wir immer wieder den folgenden Satz, der zeigt, dass jeder Vektor in zwei Teile zerlegt werden kann: 1) seine Projektion auf eine orthonormale Menge und 2) einen Rest, der orthogonal zu der gegebenen orthonormalen Menge ist.

Vermutung Sei  ein Vektorraum mit einem inneren Produkt

ein Vektorraum mit einem inneren Produkt  . Sei

. Sei  eine orthonormale Menge. Für jedes

eine orthonormale Menge. Für jedes  haben wir

haben wir , wobei

, wobei  orthogonal zu

orthogonal zu  für jedes

für jedes

Define Dann haben wir für jedes

Dann haben wir für jedes  , dass

, dass wo: In den Schritten

wo: In den Schritten  und

und  haben wir die Tatsache benutzt, dass das innere Produkt in seinem ersten Argument linear ist; im Schritt

haben wir die Tatsache benutzt, dass das innere Produkt in seinem ersten Argument linear ist; im Schritt  haben wir die Tatsache benutzt, dass

haben wir die Tatsache benutzt, dass  wenn

wenn  , da wir es mit einer orthonormalen Menge zu tun haben; im Schritt

, da wir es mit einer orthonormalen Menge zu tun haben; im Schritt  haben wir die Tatsache benutzt, dass die Norm von

haben wir die Tatsache benutzt, dass die Norm von  gleich 1 ist. Daher ist

gleich 1 ist. Daher ist  , wie oben definiert, orthogonal zu allen Elementen der orthonormalen Menge, was den Satz beweist.

, wie oben definiert, orthogonal zu allen Elementen der orthonormalen Menge, was den Satz beweist.

Der Term wird die lineare Projektion von

wird die lineare Projektion von  auf die orthonormale Menge

auf die orthonormale Menge  genannt, während der Term

genannt, während der Term  das Residuum der linearen Projektion heißt.

das Residuum der linearen Projektion heißt.

Normalisierung

Eine weitere vielleicht offensichtliche Tatsache, die wir im Gram-Schmidt-Verfahren immer wieder verwenden werden, ist, dass, wenn wir einen beliebigen Nicht-Null-Vektor nehmen und ihn durch seine Norm dividieren, das Ergebnis der Division ein neuer Vektor ist, der eine Einheitsnorm hat.

Mit anderen Worten, wenn  , dann haben wir durch die Definitheitseigenschaft der Norm, dass

, dann haben wir durch die Definitheitseigenschaft der Norm, dass

Als Konsequenz können wir definieren und durch die Positivität und absolute Homogenität der Norm, haben wir

definieren und durch die Positivität und absolute Homogenität der Norm, haben wir

Überblick über das Verfahren

Nachdem wir nun wissen, wie man einen Vektor normalisiert und wie man ihn in eine Projektion auf eine orthonormale Menge und einen Rest zerlegt, können wir das Gram-Schmidt-Verfahren erklären.

Wir werden einen Überblick über das Verfahren geben, danach werden wir es formal als Satz ausdrücken und wir werden alle technischen Details im Beweis des Satzes diskutieren.

Hier ist der Überblick.

Wir haben eine Menge linear unabhängiger Vektoren  .

.

Um den Prozess zu beginnen, normalisieren wir den ersten Vektor, d.h. wir definieren

Im zweiten Schritt projizieren wir  auf

auf  :

: wobei

wobei  das Residuum der Projektion ist.

das Residuum der Projektion ist.

Dann normalisieren wir das Residuum:

Wir werden später beweisen, dass  (damit die Normalisierung durchgeführt werden kann), weil die Ausgangsvektoren linear unabhängig sind.

(damit die Normalisierung durchgeführt werden kann), weil die Ausgangsvektoren linear unabhängig sind.

Die beiden so erhaltenen Vektoren  und

und  sind orthonormal.

sind orthonormal.

Im dritten Schritt projizieren wir  auf

auf  und

und  :

: und wir berechnen das Residuum der Projektion

und wir berechnen das Residuum der Projektion  .

.

Dann normalisieren wir es:

Wir fahren auf diese Weise fort, bis wir das letzte normalisierte Residuum  erhalten.

erhalten.

Am Ende des Prozesses bilden die Vektoren  eine orthonormale Menge, weil:

eine orthonormale Menge, weil:

-

sie das Ergebnis einer Normalisierung sind und folglich eine Einheitsnorm haben;

-

jedes

wird aus einem Rest erhalten, der die Eigenschaft hat, orthogonal zu

wird aus einem Rest erhalten, der die Eigenschaft hat, orthogonal zu  zu sein.

zu sein.

Um diesen Überblick zu vervollständigen, sei daran erinnert, dass die lineare Spannweite von  die Menge aller Vektoren ist, die als Linearkombinationen von

die Menge aller Vektoren ist, die als Linearkombinationen von  geschrieben werden können; sie wird mit

geschrieben werden können; sie wird mit bezeichnet und ist ein linearer Raum.

bezeichnet und ist ein linearer Raum.

Da die Vektoren  linear unabhängige Kombinationen von

linear unabhängige Kombinationen von  sind, kann jeder Vektor, der als Linearkombination von

sind, kann jeder Vektor, der als Linearkombination von  geschrieben werden kann, auch als Linearkombination von

geschrieben werden kann, auch als Linearkombination von  geschrieben werden. Daher stimmen die Spannweiten der beiden Vektormengen überein:

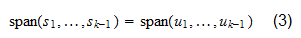

geschrieben werden. Daher stimmen die Spannweiten der beiden Vektormengen überein:

Formale Aussage

Wir formalisieren hier das Gram-Schmidt-Verfahren als einen Satz, dessen Beweis alle technischen Details des Verfahrens enthält.

Vorstellung Sei  ein Vektorraum mit einem inneren Produkt

ein Vektorraum mit einem inneren Produkt  . Seien

. Seien  linear unabhängige Vektoren. Dann gibt es eine Menge von orthonormalen Vektoren

linear unabhängige Vektoren. Dann gibt es eine Menge von orthonormalen Vektoren  , so dass

, so dass für jede

für jede  .

.

Der Beweis erfolgt durch Induktion: Zuerst beweisen wir, dass der Satz für  wahr ist, und dann beweisen wir, dass er für ein allgemeines

wahr ist, und dann beweisen wir, dass er für ein allgemeines  wahr ist, wenn er für

wahr ist, wenn er für  gilt. Wenn

gilt. Wenn  , hat der Vektor

, hat der Vektor eine Einheitsnorm und bildet für sich selbst eine orthonormale Menge: Es gibt keine anderen Vektoren, so dass die Orthogonalitätsbedingung trivialerweise erfüllt ist. Die Menge

eine Einheitsnorm und bildet für sich selbst eine orthonormale Menge: Es gibt keine anderen Vektoren, so dass die Orthogonalitätsbedingung trivialerweise erfüllt ist. Die Menge ist die Menge aller skalaren Vielfachen von

ist die Menge aller skalaren Vielfachen von  , die auch skalare Vielfache von

, die auch skalare Vielfache von  sind (und umgekehrt). Daher

sind (und umgekehrt). Daher  Nehmen wir nun an, dass der Satz für

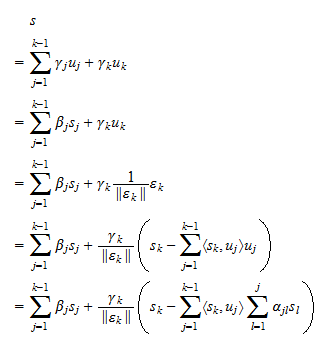

Nehmen wir nun an, dass der Satz für  wahr ist. Dann können wir

wahr ist. Dann können wir  auf

auf  :

: projizieren, wobei der Rest

projizieren, wobei der Rest  orthogonal zu

orthogonal zu  ist. Nehmen wir an, dass

ist. Nehmen wir an, dass  . Dann,

. Dann, Da durch die Annahme

Da durch die Annahme  für jede

für jede  , haben wir, dass

, haben wir, dass  für jede

für jede  , wobei

, wobei  Skalare sind. Deshalb,

Skalare sind. Deshalb, mit anderen Worten, die Annahme, dass

mit anderen Worten, die Annahme, dass  ist, führt zu dem Schluss, dass

ist, führt zu dem Schluss, dass  eine Linearkombination von

eine Linearkombination von  ist. Das ist aber unmöglich, weil eine der Annahmen des Satzes ist, dass

ist. Das ist aber unmöglich, weil eine der Annahmen des Satzes ist, dass  linear unabhängig sind. Daraus folgt, dass

linear unabhängig sind. Daraus folgt, dass  sein muss. Wir können also das Residuum normalisieren und den Vektor

sein muss. Wir können also das Residuum normalisieren und den Vektor definieren, der eine Einheitsnorm hat. Wir wissen bereits, dass

definieren, der eine Einheitsnorm hat. Wir wissen bereits, dass  orthogonal zu

orthogonal zu  ist. Dies impliziert, dass auch

ist. Dies impliziert, dass auch  orthogonal zu

orthogonal zu  ist. Somit ist

ist. Somit ist  eine orthonormale Menge. Nehmen wir nun einen beliebigen Vektor

eine orthonormale Menge. Nehmen wir nun einen beliebigen Vektor  , der als

, der als geschrieben werden kann, wobei

geschrieben werden kann, wobei  Skalare sind. Da wir durch die Annahme

Skalare sind. Da wir durch die Annahme  haben, dass Gleichung (2) auch als

haben, dass Gleichung (2) auch als geschrieben werden kann, wobei

geschrieben werden kann, wobei  Skalare sind, und: im Schritt

Skalare sind, und: im Schritt  haben wir Gleichung (1) verwendet; im Schritt

haben wir Gleichung (1) verwendet; im Schritt  haben wir die Definition von

haben wir die Definition von  verwendet. Damit haben wir bewiesen, dass jeder Vektor, der als Linearkombination von

verwendet. Damit haben wir bewiesen, dass jeder Vektor, der als Linearkombination von  geschrieben werden kann, auch als Linearkombination von

geschrieben werden kann, auch als Linearkombination von  geschrieben werden kann. Die Annahme (3) erlaubt es, die Umkehrung in völlig analoger Weise zu beweisen:

geschrieben werden kann. Die Annahme (3) erlaubt es, die Umkehrung in völlig analoger Weise zu beweisen: Mit anderen Worten: Jede Linearkombination von

Mit anderen Worten: Jede Linearkombination von  ist auch eine Linearkombination von

ist auch eine Linearkombination von  . Dies beweist, dass

. Dies beweist, dass  und schließt den Beweis ab.

und schließt den Beweis ab.

Jeder Raum mit innerem Produkt hat eine orthonormale Basis

Der folgende Satz stellt eine wichtige Konsequenz des Gram-Schmidt-Verfahrens dar.

Vorschlag Sei  ein Vektorraum mit einem inneren Produkt

ein Vektorraum mit einem inneren Produkt  . Wenn

. Wenn  endliche Dimension

endliche Dimension  hat, dann gibt es eine Orthonormalbasis

hat, dann gibt es eine Orthonormalbasis  für

für  .

.

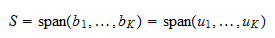

Da  endlich-dimensional ist, gibt es mindestens eine Basis für

endlich-dimensional ist, gibt es mindestens eine Basis für  , bestehend aus

, bestehend aus  Vektoren

Vektoren  . Wir können das Gram-Schmidt-Verfahren auf die Basis anwenden und erhalten eine orthonormale Menge

. Wir können das Gram-Schmidt-Verfahren auf die Basis anwenden und erhalten eine orthonormale Menge  . Da

. Da  eine Basis ist, erstreckt sie sich über

eine Basis ist, erstreckt sie sich über  . Daher

. Daher  ist

ist  eine Orthonormalbasis von

eine Orthonormalbasis von  .

.

Gelöste Aufgaben

Nachfolgend finden Sie einige Aufgaben mit erklärten Lösungen.

Übung 1

Betrachten Sie den Raum  aller

aller  Vektoren mit reellen Einträgen und dem inneren Produkt

Vektoren mit reellen Einträgen und dem inneren Produkt wobei

wobei  und

und  die Transponierte von

die Transponierte von  ist. Definiere den Vektor

ist. Definiere den Vektor

Normalisiere  .

.

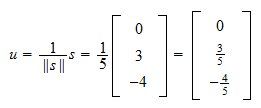

Die Norm von  ist

ist Daher, ist die Normierung von

Daher, ist die Normierung von

Übung 2

Betrachten Sie den Raum  aller

aller  Vektoren mit reellen Einträgen und dem inneren Produkt

Vektoren mit reellen Einträgen und dem inneren Produkt wobei

wobei  . Betrachte die beiden linear unabhängigen Vektoren

. Betrachte die beiden linear unabhängigen Vektoren

Transformiere sie mit Hilfe des Gram-Schmidt-Verfahrens in eine orthonormale Menge.

Die Norm von  ist

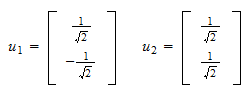

ist  Daher, ist der erste orthonormale Vektor

Daher, ist der erste orthonormale Vektor Das innere Produkt von

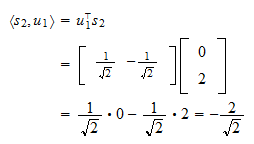

Das innere Produkt von  und

und  ist

ist Die Projektion von

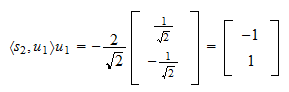

Die Projektion von  auf

auf  ist

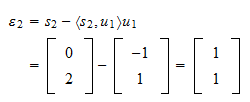

ist Das Residuum der Projektion ist

Das Residuum der Projektion ist Die Norm des Residuums ist

Die Norm des Residuums ist und das normierte Residuum ist

und das normierte Residuum ist Das heißt, ist die gesuchte orthonormale Menge

Das heißt, ist die gesuchte orthonormale Menge

Zitierweise

Bitte zitieren als:

Taboga, Marco (2017). „Gram-Schmidt-Prozess“, Vorlesungen zur Matrixalgebra. https://www.statlect.com/matrix-algebra/Gram-Schmidt-process.

Leave a Reply